Когда владельцы сайтов создают и размещают новый контент, они стремятся, чтобы их страницы входили в результаты поиска и привлекали потенциальных посетителей. Однако иногда бывает наоборот – некоторые страницы должны быть исключены из поисковых запросов. Возможные причины таких действий могут быть разными: копирование контента, отсутствие актуальной информации, дубликаты страниц и другие. В данной статье мы рассмотрим, как удалить страницы сайта из поиска Яндекс.

Яндекс – одна из крупнейших поисковых систем в России, и доля ее рынка продолжает расти. Поэтому многие владельцы сайтов заинтересованы в том, чтобы их сайты показывались в результатах поиска Яндекс. Однако, иногда бывает необходимо скрыть определенные страницы от поиска. Дело в том, что поисковые роботы Яндекса постоянно сканируют веб-страницы и индексируют их. Но владельцы сайтов имеют возможность удалить определенные страницы из поисковых запросов Яндекса с помощью специальных инструментов.

К счастью, существует несколько способов удалить страницы сайта из результатов поиска Яндекс. Владельцы сайтов могут использовать файл robots.txt для указания инструкций по индексации поисковыми роботами. Также они могут воспользоваться инструментом Яндекс.Вебмастер, где они смогут удалить все страницы сайта или лишь отдельные страницы из поискового индекса Яндекса. Оба способа позволяют владельцам сайтов контролировать, какие страницы должны быть исключены из поисковых запросов Яндекс, чтобы улучшить качество поисковой выдачи.

Как удалить страницы сайта из поиска Яндекс

Всем веб-мастерам важно контролировать информацию о своем сайте в результатах поиска, чтобы представлять только актуальное и релевантное содержание для посетителей. Если у вас есть страницы на вашем сайте, которые вы хотите исключить из поиска Яндекс, есть несколько способов сделать это.

1. Первый способ — использование файла robots.txt. Создайте файл с именем robots.txt и разместите его на корневом уровне вашего сайта. Внутри файла вы можете указать, какие страницы не нужно индексировать поисковыми роботами Яндекса. Например, чтобы исключить страницу с URL-адресом «http://www.example.com/not-indexed-page.html» из поиска, вам нужно добавить следующую строку в файл robots.txt:

User-agent: Yandex

Disallow: /not-indexed-page.html

2. Второй способ — использование мета-тега noindex. В коде каждой страницы, которую вы хотите исключить из поиска, добавьте следующий мета-тег:

<meta name=»robots» content=»noindex»>

Если вы хотите исключить несколько страниц из поиска, вы можете использовать разные методы для разных страниц, в зависимости от вашего уровня контроля над их содержимым. Оба способа описанные выше эффективно работают с поисковым роботом Яндекса и помогут вам удалить выбранные страницы из результатов поиска.

Использование файла robots.txt

Файл robots.txt имеет простой формат и легко создается и редактируется. Он создается в текстовом формате без каких-либо специфических требований к кодировке. Для создания файла robots.txt достаточно использовать обычный текстовый редактор, сохранить файл с названием «robots.txt» и разместить его на корневом уровне сервера сайта.

Структура файла robots.txt

Файл robots.txt состоит из нескольких элементов: правило, User-agent, и Disallow. User-agent представляет собой название поискового робота, а Disallow указывает путь к страницам, которые необходимо исключить из индексации. Если нужно заблокировать доступ поисковым ботам ко всем страницам сайта, достаточно указать в Disallow символ «/». Таким образом, robots.txt может содержать несколько правил, каждое из которых относится к отдельному поисковому роботу или к группе роботов.

Важно отметить, что наличие файла robots.txt не означает, что поисковые роботы обязательно его используют. Индексирование сайта зависит от спецификации робота и его политики. Однако файл robots.txt предоставляет возможность влиять на процесс индексации и контролировать видимость страниц в поисковых системах.

Инструкции для поисковых роботов

Файл «robots.txt» предоставляет поисковым роботам указания о том, какие страницы сайта нужно индексировать, а какие — игнорировать. Он размещается в корневой директории сайта и содержит правила для поисковых роботов. Правильное использование файла «robots.txt» позволяет оптимизировать индексацию и улучшить видимость и ранжирование вашего сайта в поисковой системе.

Пример использования тегов

- Чтобы пометить текст как важный, вы можете использовать тег strong.

- Создание списка можно осуществить с помощью тега

- и элементов списка — тега

- .

- Если нужно создать нумерованный список, вместо

- используйте

- .

Метод Описание GET Запрос данных с сервера POST Отправка данных на сервер для обработки PUT Обновление данных на сервере DELETE Удаление данных на сервере Использование инструментов Яндекса для удаления страниц

В данной статье мы рассмотрели, как удалить страницы сайта из поиска Яндекса. Но помимо указанных методов, Яндекс также предоставляет специальные инструменты для удаления страниц из своей поисковой системы.

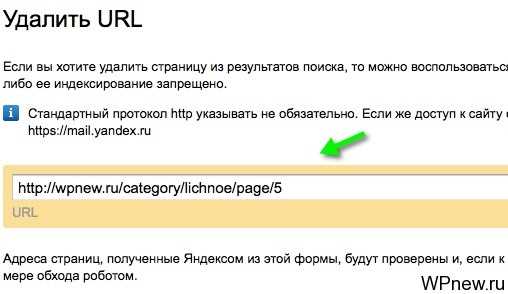

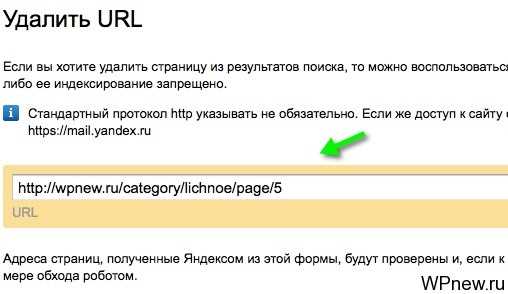

Первым и наиболее простым инструментом является Форма исключения страницы, которая доступна в Яндекс.Вебмастере. Чтобы воспользоваться этим инструментом, необходимо зарегистрироваться в Яндекс.Вебмастере и подтвердить право собственности на сайт. Затем в разделе «Индексирование» можно указать страницы, которые нужно исключить из поиска. Яндекс будет регулярно проверять эти страницы и исключать их из своего индекса.

Еще одним полезным инструментом является Функция «Удалить из поиска», которую можно найти на странице с результатами поиска Яндекса. Если вы обнаружили страницу своего сайта с нежелательным содержимым в поиске, вы можете воспользоваться этой функцией, чтобы временно скрыть данную страницу из результатов поиска. При этом Яндекс проанализирует страницу и примет соответствующие меры.

Используя эти инструменты, вы сможете управлять видимостью и доступностью страниц вашего сайта в поиске Яндекса. Будьте внимательны при удалении страниц, чтобы не исключить важные материалы, которые должны быть доступны для пользователей. И помните, что удаление страниц из поиска это лишь способ скрыть контент от общественности, но не способ его полного удаления из интернета.